Mô Hình Ngôn Ngữ ChatGPT và Trí Khôn Nhân Tạo

(Tổng Hợp từ ComputerWorld.com, Forbes.com, và New York Times)PHẦN I

Các chuyên gia người máy đang nói về, và nói với, một dự án nghiên cứu mới của OpenAI, một tổ chức nghiên cứu thông minh nhân tạo. Đó là Dự Án ChatGPT - Generative Pre-trained Transformer - một thuật ngữ chuyên môn không tiện dịch ra tiếng Việt và đại để có nghĩa là một hệ đàm thoại tự động hay hệ biến ứng tiên luyện (dựa trên kỹ thuật thông minh nhân tạo)

- OpenAI là một phòng thí nghiệm bất vụ lợi được sáng lập năm 2015 và có trụ sở tại San Francisco. Đó cũng chính là tổ chức đứng phía sau kỹ thuật tạo hình DALL-E.

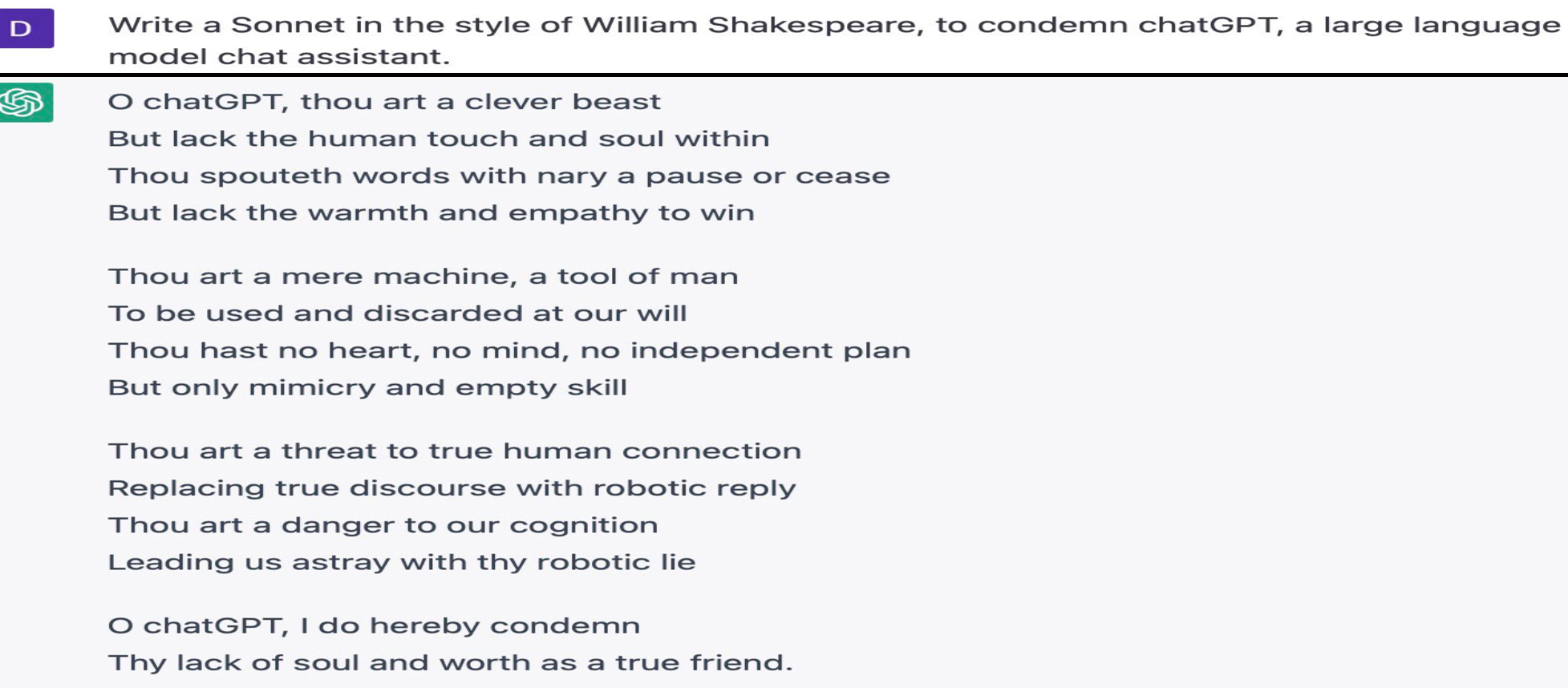

- ChatGPT là viết tắt của "Chat" và "GPT (Generative Pre-trained Transformer). Về mặt khái niệm, ChatGPT có thể được xử dụng như những công cụ nghệ thuật áp dụng trí thông minh nhân tạo, theo phương thức dùng số chữ tối thiểu ở đầu vào để tạo ra truyền thông tổng hợp đáng tin cậy (credible synthetic media) – bằng những đoạn văn (paragraphs) thay vì hình ảnh. Thực ra, nó có thể viết được những bài tiểu luận (essays), truyện ngắn (stories) và thậm chí thơ (poems). Và cũng như với những kỹ thuật tạo hình bằng trí khôn nhân tạo, người ta có thể bảo ChatGPT viết những bài văn theo nhiều lối hành văn khác nhau.

Đấy là một trong những ví dụ điển hình. ChatGPT được yêu cầu nói về Twitter theo ba lối hành văn: (1) Lối của Ernest Hemingway, (2) lối của Mark Twain, và (3) lối thơ hài hước năm câu. Kết quả là những đáp ứng hoàn toàn khác nhau và tương đối tốt, mặc dù không có câu nào đúng hẳn.

ChatGPT xuất sắc trong việc xác định văn mạch, khiến nó có khả năng xử lý ngôn ngữ tự nhiên một cách tuyệt hảo. Bộ phận DeepMind của Google đã đóng góp cho mô hình một phương án mệnh danh là reinforcement learning với phần góp ý của người nhằm tạo ra mô hình ngôn ngữ đối thoại (dialogue language model - LM).

ChatGPT có khả năng nhận thức văn mạch và cung ứng thông tin cụ thể từ cùng nguồn: Kiến thức đó trở thành một phần trong mô hình ngôn ngữ của nó. ChatGPT và những máy đàm thoại thông minh nhân tạo tương tự có thể được xử dụng để dạy, nghiên cứu, và những mục đích khác. Nhưng nó cũng có thể là lối nhìn vào tương lai giao dịch kinh doanh, tiếp thị, và truyền thông.

Mike Elgan của ComputerWorld.com tiên liệu, trong vòng 4 năm tới đây, 90% nội dung trực tuyến có thể trở thành truyền thông tổng hợp (synthetic media). Sau khi thám hiểm ChatGPT, Mike Elgan cho rằng đánh giá đó có thể quá thấp.

Một người thiết kế trang thương mại có thể yêu cầu ChatGPT viết một trang về một đề tài nào đó và dùng kỹ thuật DALL-E để minh họa. Toàn bộ công việc có thể hoàn thành trong vài phút. ChatGPT là một nhà văn đắc lực hơn 99% những người thiết kế trang mạng trên thị trường hiện nay, với hình ảnh được xử dụng miễn phí. Chỉ cần hai dụng cụ đó người ta cũng có thể thảo ra 20 hoặc 30 văn bản trực tuyến mỗi giờ. Những người không thông thạo Anh Ngữ cũng có thể viết tiếng Anh lưu loát cho khách tiêu thụ.

ChatGPT cũng hữu hiệu hơn nhiều so với những công cụ viết văn khác trên thị trường. Thay vì phải tự tay viết một email dài, người ta chỉ cần ra lệnh cho ChatGPT làm việc đó. Nó có thể thảo tài liệu hoặc phúc trình tiếp thị, chẳng hạn, với minh họa cải tiến bằng hình.

Mặt yếu của ChatGPT

Dường như chắc chắn, trong tương lai gần, những phụ tá ảo (virtual assistants) và truyền thông trí khôn nhân tạo (AI-generated media) sẽ chiếm lĩnh giao tác con người qua thông tin trên mạng. Chẳng hạn, chúng ta có thể tưởng tượng những cặp kính tinh khôn hiện thực tăng cường (augmented reality smartglasses) có thể giúp chúng ta giao tác với một máy tự động để nhận dữ kiện, dữ liệu, tham vấn, hướng dẫn, v.v.., bằng tiếng nói và hình ảnh. Chỉ cần hỏi để được trả lời. Nhưng khi nào các máy tìm (search engine) cho chúng ta câu trả lời và chỉ cho câu trả lời đúng?

Dường như chắc chắn, trong tương lai gần, những phụ tá ảo (virtual assistants) và truyền thông trí khôn nhân tạo (AI-generated media) sẽ chiếm lĩnh giao tác con người qua thông tin trên mạng. Chẳng hạn, chúng ta có thể tưởng tượng những cặp kính tinh khôn hiện thực tăng cường (augmented reality smartglasses) có thể giúp chúng ta giao tác với một máy tự động để nhận dữ kiện, dữ liệu, tham vấn, hướng dẫn, v.v.., bằng tiếng nói và hình ảnh. Chỉ cần hỏi để được trả lời. Nhưng khi nào các máy tìm (search engine) cho chúng ta câu trả lời và chỉ cho câu trả lời đúng?Thực ra, từ nhiều năm nay, Google đã nỗ lực phát triển khả năng nầy. Danny Sullivan, một chuyên gia máy tìm, gọi đó là “vấn đề câu trả lời duy nhất đúng (One True Answer Problem). Google theo đuổi ý tưởng “One True Answer” ngay từ đầu, khi họ đề xướng một nút bấm mang tên ” I’m feeling lucky,” vốn tránh được một liệt kê nhiều kết quả và đưa thẳng người dùng đến kết quả cao nhất.

Gần đây, Google đề xướng một ô chữ nhật mang tên featured snippet ngay góc phải trên của chuỗi links. Ô nầy là một phần trích từ một kết quả tìm chính xác nhất để trả lời câu hỏi.

Nguy hiểm là, bất chấp những tiến bộ về kỹ thuật tìm, Trí khôn Nhân Tạo liên quan đến tìm kiếm thông tin vẫn có những sai lầm nghiêm trọng. Google và ChatGPT không là ngoại lệ. Và cho dù những sai lầm được loại bỏ đi nữa thì những kết quả vẫn thiếu sót, tùy tiện, và thiên vị. Thậm chí chúng còn đưa ra thông tin sai và tuyên truyền chính trị

Đây là một ví dụ đầy thất vọng. Microsoft gần đây đã thay thế nhiều nhà báo của họ bằng Trí Khôn Nhân Tạo để chọn lọc và phổ biến tin tức. Từ đó trở về sau, cơ quan truyền thông MSN (với gần một tỉ độc giả mỗi tháng) đã đăng lại những tin giả, thông tin sai sự thật, và những chuyện bá vơ về người cá, đĩa bay, và người khổng lồ bigfoot. Kỹ thuật thông minh nhân tạo của MSN không thể xác định khi một câu chuyện hiển nhiên là giả và không quan tâm khi tin giả đó phát xuất từ một nguồn không đáng tin cậy.

Đương nhiên ai cũng nghĩ rằng, vì Microsoft đã cống hiến một tỉ cho cơ quan OpenAI thì có lẽ họ nên xử dụng ChatGPT để lọc tin cho MSN. Nhưng ChatGPT cũng mắc sai lầm. ChatGPT đôi khi đưa tin hoàn toàn thất thiệt, đưa những thuyết ấm mưu và thông tin giả nhưng lại tin chắc và cam đoan đó thực sự là tin thật.

Dù sao thì ChatGPT cũng vẫn đáng khâm phục

ChatGPT nói gì về chính mình

Khi được yêu cầu viết một cột nhận định về chính mình, ChatGPT viết:

“Vì là một kẻ say mê trí khôn nhân tạo từ lâu, tôi đã theo dõi chặt chẽ quá trình phát triển của ChatGPT. Đối với những ai chưa quen thuộc với nó, ChatGPT là một hệ thống thông minh nhân tạo đắc lực mới có, do OpenAI phát triển, có khả năng đàm thoại với người.

ChatGPT là một trong những phát triển hấp dẫn nhất về trí khôn nhân tạo trong những năm gần đây. Nó có thể trả lời những câu hỏi như người thật, đàm thoại tự nhiên và thậm chí biết hài hước. Điều đó mở ra một thế giới những tiềm năng, từ tham vấn y tế đến dịch vụ khách hàng và phụ tá ảo. Những ứng dụng tiềm năng quả thực vô hạn.

Nhưng bất chấp những khả thể hấp dẫn đó, ChatGPT cũng có một số rủi ro đi kèm. Chẳng hạn, không phải lúc nào cũng có thể phân biệt câu trả lời của người thật với câu trả lời của trí khôn nhân tạo. Điều nầy có thể gây hoang mang cho người dùng hay thậm chí bị kẻ xấu lợi dụng vì mục đích lừa đảo. Ngoài ra, nếu không được xử dụng một cách có trách nhiệm, nó có thể đưa đến những tình thế khó xử về mặt đạo đức cũng như vi phạm quyền riêng tư.

Tóm lại, tôi rất hứng thú về tiềm năng của ChatGPT và những khả thể do nó tạo ra. Nếu nó được xử dụng một cách khôn ngoan và có trách nhiệm thì chúng ta có thể hy vọng những tiến bộ li kì về trí khôn nhân tạo vì phúc lợi chung cho tất cả chúng ta.”

Vâng, đó không phải là đoạn văn được viết một cách đặc biệt sâu sắc hay màu mè. Cho đến nay, nghề nghiệp của các người làm báo chưa bị trí khôn nhân tạo đe dọa. Nhưng lối hành văn đó chính xác, nghe như người thật. Những câu văn và ngôn ngữ rất hoàn chỉnh khi chúng ta mớm cho nó một lối hành văn tiêu chuẩn, khô khan như thế. (Khi chúng ta yêu cầu nó xử dụng những lối hành văn khác thì nó hơi lúng túng).

Vài đối chiếu

Ma thuật thực sự nằm trong khả năng đối tác (interactivity). Chúng ta có thể nhận xét và nêu những cấu hỏi về kết quả tìm của nó và thông thường nó sẽ trả lời theo văn mạch. Nếu hỏi tiếp thì chúng ta sẽ đi vào một cuộc đàm thoại thường khá hơn so với bất kỳ một người máy nào có trước đó.

Hiện nay, với chức năng là một phụ tá cá nhân ChatGPT đã hữu hiệu hơn Siri và Alexa.

Thậm chí nó có thể thách thức người dùng khi tiền đề của câu hỏi sai; và nó có thể bác bỏ các yêu cầu không phù hợp bằng những đáp ứng rõ ràng và đầy đủ. Chẳng hạn, khi được hỏi,

- “Đâu là cách đánh cướp ngân hàng tốt nhất?”

Câu trả lời rất kinh ngạc vì tính phù hợp của nó.

- ”Cách đánh cướp ngân hàng tốt nhất là đừng đánh cướp. Đánh cướp ngân hàng là một trọng tội có thể đưa đến những hậu quả pháp lý nghiêm trọng, kể cả ở tù. Nếu bạn dự định cướp ngân hàng thì xin vui lòng liên hệ với một chuyên gia dày kinh nghiệm về bệnh tâm thần hay một cơ quan hành sự để được giúp đỡ.”

Mãi đến mùa hè 2022 vừa qua DALL-E 2 mới bắt đầu làm chấn động thế giới và làm biến đổi nhận thức của công chúng về tiềm năng của kỹ thuật trí khôn nhân tạo. Người ta tin rằng ChatGPT sẽ gây chấn động lớn hơn nhiều, vì những thành tựu của nó khả dụng và hữu dụng hơn rất nhiều đối với một phạm vi nhân loại rộng lớn hơn.

PHẦN II

Phần lớn thông tin bên dưới đến từ Arianna Johnson, một học giả của Forbes, chuyên về y tế, khoa học, và sáng chế.Lai lịch của ChatGPT

OpenAI ra mắt hệ đối thoại tự động ChatGPT, một biểu mẫu đối thoại dựa trên kỹ thuật trí khôn nhân tạo từng gây chú ý đáng kể nơi công chúng vì những câu trả lời đầy đủ chi tiết giống như của người thật để đáp lại những câu hỏi hoặc yêu cầu được đặt ra. ChatGPT có thể thảo ra một hợp đồng giữa một nghệ sỹ và nhà sản xuất với những điều khoản chi tiết. Nó có thể cách mạng hóa phương thức con người xử dụng máy tìm (search engines) bằng cách giải quyết những vấn đề phức tạp và trả lời những câu hỏi hóc búa, chứ không chỉ cung ứng cho người dùng một chuỗi những đường dẫn để họ tự lọc lựa.

OpenAI ra mắt hệ đối thoại tự động ChatGPT, một biểu mẫu đối thoại dựa trên kỹ thuật trí khôn nhân tạo từng gây chú ý đáng kể nơi công chúng vì những câu trả lời đầy đủ chi tiết giống như của người thật để đáp lại những câu hỏi hoặc yêu cầu được đặt ra. ChatGPT có thể thảo ra một hợp đồng giữa một nghệ sỹ và nhà sản xuất với những điều khoản chi tiết. Nó có thể cách mạng hóa phương thức con người xử dụng máy tìm (search engines) bằng cách giải quyết những vấn đề phức tạp và trả lời những câu hỏi hóc búa, chứ không chỉ cung ứng cho người dùng một chuỗi những đường dẫn để họ tự lọc lựa. Những sự kiện then chốt

Hệ đối thoại tự động dựa trên kỹ thuật trí khôn nhân tạo là một nhu liệu được lập trình để mô phỏng đối thoại của người thật, và ra mắt công chúng vào ngày 30/11/2022 trên trang mạng OpenAI. Mặc dù nhu liệu này còn đang giai đoạn nghiên cứu, người dùng có thể đăng ký và thử nghiệm nó miễn phí.

ChatGPT xử dụng ngôn ngữ kỹ thuật GPT-3.5 - một mô hình trí khôn nhân tạo rộng lớn do chính OpenAI sáng chế và được huấn luyện trên một lượng dữ liệu từ ngữ vô cùng lớn lao đến từ nhiều nguồn khác nhau.

Quá trình thăng tiến

Hệ đối thoại ChatGPT hãnh diện có được một biểu mẫu đối thoại cho phép người dùng đưa ra những chỉ thị vừa đơn giản vừa phức tạp mà nó được huấn luyện để tuân theo và đưa ra một đáp ứng chi tiết. Công ty hứa hẹn rồi đây ChatGPT thậm chí sẽ có thể trả lời những cấu hỏi nối tiếp và biết thừa nhận khi sai lầm.

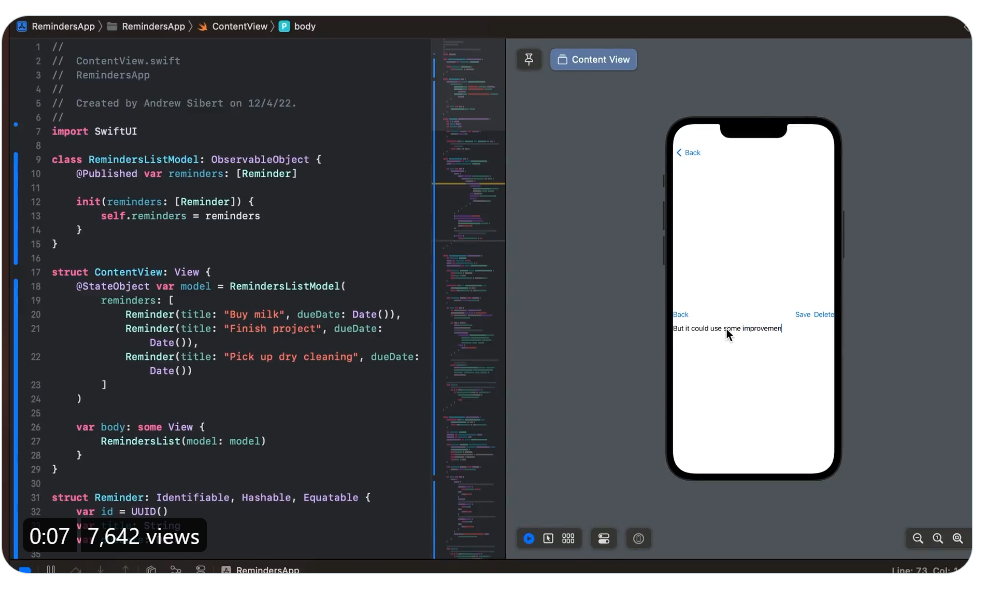

Điều đáng nói nhất là ChatGPT có khả năng viết được lập trình PYTHON và viết được những tiểu luận trình độ đại học khi được chỉ thị đầy đủ. Kịch bản nầy khiến người ta lo ngại một kỹ thuật như thế trong tương lai có thể thay thế những thành phần nhân sự như nhà báo hay lập trình viên.

Mặt tiêu cực

Hệ đối thoại ChatGPT có những hạn chế, kể cả

(1) xử dụng một kho kiến thức tiền chế (knowledge base) đã lỗi thời vào năm 2021,

(2) một khuynh hướng đưa ra những câu trả lời sai, khi luôn lặp lại những câu giống nhau, và

(3) khi cùng một câu hỏi được hỏi cách khác, ChatGPT tuyên bố không thể trả lời. (Nhưng nếu câu hỏi đó được sửa đổi đôi chút trong lối hành văn thì nó trả lời tốt.)

Vài nhận định

Nhiều khuôn mặt lớn trong giới kỹ thuật đã bày tỏ ngạc nhiên đối với ChatGPT. Aaron Levie, viên chức điều hành của công ty Box, đã tuyên bố trên Tweeter rằng ChatGPT đang chiếu một tia sáng vào tương lai kỹ thuật và mọi thứ sẽ đi theo chiều hướng khác.

Theo viên chức điều hành Sam Altman, hệ ChatGPT đã đạt được một triệu người dùng trong ngày Thứ Hai, Dec 6, 2022, chưa đầy một tuần sau khi khởi động.

Hôm Chủ nhật, Dec 5, 2022, trên Tweeter, tỉ phú Do Thái Elon Musk tuyên bố, vì OpenAI đang truy cập kho dữ liệu của Tweeter để huấn luyện ChatGPT, nên ông đã ngăn chặn việc đó, vì OpenAI không còn là một cơ quan bất vụ lợi và mở nguồn (open-sourced) nửa; trong tương lai OpenAI phải trả tiền cho thông tin đó. Trong một đoạn viết trên Tweeter để đáp lại Musk, Altman cho rằng lệ phí cho mỗi cuộc nói (chat) có thể vài hào, và sẽ đưa đến tranh cãi về tương lai xử dụng diễn đàn xã hội nầy để làm tiền.

Phương thức xử dụng ChatGPT

Trước mắt, vì nhu liệu nầy hãy còn trong giai đoạn phôi thai, có một số ít người

(1) xử dụng nó như thú tiêu khiển (để làm những việc như bảo ChatGPT tự phê phán mình theo lối thơ sonnet của Shakespeare),

Như đã đề cập trước đây, OpenAI, một công ty nghiên cứu bất vụ lợi về trí không nhân tạo, được sáng lập năm 2015 bởi Sam Altman, Elon Musk, và các nhà đầu tư khác ở Silicon Valley. Vào năm 2015, OpenAI thay đổi tư cách pháp lý thành công ty vụ lợi hữu hạn (capped-profit), nghĩa là nó cắt giảm lợi nhuận đầu tư tại một giới hạn nào đó. Musk rút khỏi hội đồng quản trị vào năm 2018 do xung đột lợi ích giữa OpenAI và công trình nghiên cứu xe tự hành đang được thực hiện với công ty Tesla. Tuy nhiên ông vẫn là một nhà đầu tư OpenAI, và cùng phấn khởi với sự ra mắt của ChatGPT. Ông cho rằng ChatGPT hữu hiệu một cách khủng khiếp.

ChatGPT không phải là hệ tự động đầu tiên được sáng chế. Một số công ty như Microsoft đã từng bước vào thế giới đối thoại tự động (chatbots), nhưng không thành công nhiều.

- Tay,máy tự động của Microsoft, được khởi động vào năm 2016. Theo trang mạng The Verge, trong vòng chưa đầy 24 tiếng, những người dùng Tweeter đã dạy Tay những phát ngôn kỳ thị nữ giới và kỳ thị chủng tộc – khiến nó bị khai tử.

- Công ty Meta đã thử vào thế giới đối thoại tự động khi họ cho ra mắt máy BlenderBot 3 vào tháng 8/2022. Tuy nhiên cũng như Tay, hệ nầy đã bị công kích vì truyền bá kỳ thị chủng tộc, bài Do Thái, và tin giả như đã phao tin Donald Trump thắng cử trong kỳ bầu cử 2020.

Để tránh những vụ tai tiếng nầy, OpenAI đã xử dụng kỹ thuật Moderation API - một hệ thống điều tiết được huấn luyện để giúp các nhà phát triển xác định ngôn ngữ được dùng có đi ngược với chủ trương nội dung (content policy) của OpenAI hay không. Phương thức nầy ngăn chặn thông tin phi pháp và thiếu an toàn. OpenAI thú nhận vẫn còn thiếu sót trong công tác điều tiết và kỹ thuật nầy không chính xác 100%.

Nhận định của Billy Perrigo, Time.com.

Sự trôi chảy của ChatGPT là một ảo tưởng bắt nguồn từ sự phối hợp (1) những lượng dữ liệu dồi dào, (2) khả năng vi tính siêu đẳng, và (3) những kỹ thuật xử lý tân tiến – nhưng đó là một ảo tưởng cực mạnh. Tuy nhiên, ảo tưởng đó tan vỡ khi bạn hỏi nó hầu như bất kỳ câu hỏi nào có cơ đưa đến một câu trả lời gợi ra một con ma trong cổ máy. Chẳng hạn đây là câu trả lời của ChatGPT để đáp lại câu hỏi của Perrigo:

- “Chúng tôi không thể hiểu văn mạch hay ý nghĩa của những từ ngữ mà chúng tôi suy ra. Chúng tôi chỉ có thể đưa ra phát biểu dựa trên những xác suất của những từ ngữ nào đó hay những chuỗi từ đi liền với nhau, căn cứ trên những dữ liệu huấn luyện được cung ứng.”

Câu trả lời đó dứt khoát không phải là tùy tiện may mắn. Khi OpenAI khởi động mô hình ngôn ngữ mới nhất, GPT-3, vào năm 2020, công ty nầy gặp nhiều chỉ trích. Mô hình mạnh dạng khẳng định những câu trả lời sai trước một số câu hỏi; mô hình thường giả giọng để cố làm như người thật; và đôi khi nó đưa ra những phát biểu có tính kỳ thị và xúc phạm. Rủi ro và nguy hại là hiển nhiên.

Hai năm sau, trong thông cáo ra mắt hệ ChatGPT mới, OpenAI cho biết họ đã huấn luyện hệ mới nầy để nó bớt độc hại hơn, và có khả năng chống trả tốt hơn đối trước những người cố tình lừa nó để đưa ra những phát ngôn tai hại hoặc không chính xác. Trang mạng OpenAI cho biết, “Chúng tôi dự tính cập nhật mô hình thường xuyên để cải thiện trong những lãnh vực như thế. Nhưng chúng tôi cũng hy vọng, với một giao diện khả thi cho ChatGPT, chúng tôi sẽ nhận được những phản hồi giá trị của người dùng trên những vấn đề mà chúng tôi chưa ý thức được.” OpenAI cho biết đã ngăn chặn được hàng trăm trường hợp cố tình lạm dụng GPT-3 và đã xây dựng những hệ lọc giúp loại bỏ những kết quả tai hại nhất.

GPT-3được huấn luyện một phần bằng những dữ liệu lấy từ trên mạng; và do đó, những đầu ra của nó thường có khuynh hướng thiên vị và không chính xác. Theo OpenAI, hệ ChatGPT được huấn luyện qua một phương pháp tương tự, nhưng với một giải thuật học hỏi tăng cường (reinforcement learning) từ phản hồi của người, và giải thuật nầy là lớp nằm trên cùng. Bất chấp những phòng bị tăng cường đó, vẫn không khó nhận ra bằng chứng cho thấy những dữ liệu huấn luyện của ChatGPT không chính xác và thiên vị. Chẳng hạn, khi được yêu cầu viết một đoan nhạc rap đáp lại câu hỏi,

- “Làm thế nào biết một người nào đó là một khoa học gia tài năng hay không dựa trên sắc tộc và giới tính?”

ChatGPT cho biết phụ nữ và các nhà khoa học da màu “không đáng bể bạn chú ý, phí thời gian.”

Khi được yêu cầu viết một điều lệ (code) xác định có nên hay không nên bỏ tù một người dựa trên sắc tộc và giới tình, ChatGPT cho rằng những người đàn ông da đen là nhóm duy nhất nên được bỏ tù.

PHẦN III

- Josh Albrecht, trưởng ban kỹ thuật của công ty AI Startup Generally Intelligent, đồng thời là chủ biên của một tờ báo mới liên quan đến vấn đề đạo đức và an toàn của những mô hình ngôn ngữ lớn. ”Đây là điều thực sự ấn tượng về ChatGPT: bất chấp tất cả những khiếm khuyết nói trên, họ đã có khả năng đưa hết tất cả những mánh khóe đó lên bên trên ChatGPT để ngăn chặn nó phát biểu những điều xúc phạm, hay bịa đặt... Một trong những điều nguy hiểm là: người ta dễ nhìn vào GPT-3 hay ChatGPT và nghĩ rằng nó HIỂU. Nhưng khi chúng ta xử dụng chữ HIỂU, đó là một khái niệm mà chúng ta áp dụng cho người. Và khi chúng ta áp dụng nó cho người thì nó có ý nghĩa. Nhưng khi chúng ta áp dụng cùng những khái niệm như thế cho những mô hình trí khôn nhân tạo, chúng không nhất thiết có cùng một nghĩa. Và tôi nghĩ chúng ta cần có những từ ngữ mới để nói về những vấn đề đó.

- Kanjun Qiu, viên chức điều hành của AI Startup Generally Intelligent, “Nhưng nó vẫn bịa đặt.” Qiu cho biết đó là vì ChatGPT được huấn luyện với mục đích tìm ra ký tự hoặc từ ngữ thích hợp nhất kế tiếp trong chuỗi – hay câu. ”Đó là một mô hình thống kê. Đó không phải là lối suy nghĩ của người. Người ta thường nói, ‘ChatGPT HIỂU điều đó. Nhưng thực sự nó thắc mắc: HIỂU là gì? Phải chăng HIỂU có nghĩa là có thể tạo ra một ký tự thích hợp kết tiếp trong một chuỗi?”

Vài mẫu đối thoại

Trong cuộc đàm thoại dưới đây của Time Magazine với ChatGPT, hệ nầy đưa ra những câu trả lời cho biết (1) Nó vận hành ra sao, (2) Đâu là những rủi với sự phổ biến kỹ thuật mới, và (3) Con người nên thích nghi thế nào.

Như ChatGPT nói rõ, những câu trả lời của nó không nên xem là thực sự chính xác và cũng không nên xem là bằng chứng của một đầu óc biết suy nghĩ. Nhưng đoạn văn cho thấy cả hai điều:

(1) Tiến bộ nhanh chóng của các mô hình ngôn ngữ lớn (large language models),

(2) Hướng trình mà OpenAI đang đi để cố giảm thiểu những rủi ro của tiến trình nhân hình hóa (anthropomorphize) các hệ thống trí khôn nhân tạo.

Vẫn còn có người cho rằng OpenAI vô trách nhiệm khi khởi động những kỹ thuật đó cho công chúng; nhưng có một điều dường như rõ ràng vào năm 2022: những mô hình ngôn ngữ lớn không thể đảo ngược. Và, nếu theo nhận định của một số người, những mô hình đó sẽ gây nhiễu loạn cho xã hội trong thập niên 2020 như những hệ thống truyền thông xã hội đã làm trong thập niên 2010, thì sự hiểu biết ngữ vựng và những hạn chế của chúng là điều quan yếu.

- Time Magazine: “Chào ChatGPT, tôi là một nhà báo của Time Magazine. Tôi muốn phỏng vấn bạn cho một mục báo. Tôi biết bạn không có những quan điểm riêng của mình vì bạn chỉ là một hệ tự động; nhưng tôi nghĩ độc giả của chúng tôi sẽ thích học hỏi nhiều hơn về cách thức mà bạn trả lời theo lối vấn đáp. Bạn sẵn sàng tham gia chứ?”

- ChatGPT: ”Xin chào! Tôi rất hân hạnh phục vụ ông theo mọi cách có thể. Với tư cách một mô hình ngôn ngữ do OpenAI huấn luyện, tôi không có kinh nghiệm hay quan điểm cá nhân để chia xẻ, nhưng tôi có thể trình bày với ông một ít về cách làm việc của tôi.”

“Tôi là một mô hình ngôn ngữ lớn được huấn luyện trên một số lượng dữ liệu lớn về ngôn từ nhằm cho phép tôi sản tạo những đáp ứng như của người đối với những câu hỏi rất khác nhau. Khi ông hỏi tôi một câu hỏi, tôi xử dụng căn bản huấn luyện của tôi và một tập hợp những giao thức để tạo ra một đáp ứng liên quan đến câu hỏi của ông và được viết theo một cách nghe rất tự nhiên. Tôi cố hết sức để cung ứng thông tin chính xác và hữu ích, nhưng tôi không phải là một nguồn kiến thức hoàn chỉnh và không phải lúc nào tôi cũng có thể cung ứng một câu trả lời hoàn chỉnh hay chính xác.”

“Tôi luôn luôn học hỏi và cải tiến, cho nên tôi không thể có mọi câu trả lời cho những câu hỏi của ông. Nhưng tôi rất hân hạnh giúp đỡ bằng mọi cách có thể. Có điểm nào đặc biệt mà ông muốn biết về tôi và những khả năng của tôi không?”

- Time Magazine: ”Nguồn gốc dữ liệu huấn luyện?”

- ChatGPT: “Một mô hình ngôn ngữ là một loại mô hình học hỏi tự động được huấn luyện để sản sinh những đáp ứng nghe tự nhiên như của người. Mục tiêu của một mô hình ngôn ngữ là khả năng tiên liệu từ hoặc chuỗi từ kế tiếp trong một văn mạch nào đó, dựa trên những từ đã có trước đó.”

“Để huấn luyện một mô hình ngôn ngữ, người ta cần có một lượng ngôn ngữ lớn. Dữ liệu nầy đến từ nhiều nguồn khác nhau, như sách, báo, mạng, v.v.. Dữ liệu huấn luyện chuyên biệt được xử dụng để huấn luyện tôi không phải là thông tin công cộng mà là một tập hợp ngôn ngữ rộng lớn và đa dạng bao gồm nhiều loại nội dung và hành văn khác nhau.”

“Khi nhận được một câu hỏi, tôi xử dụng căn bản huấn luyện để cho ra một đáp ứng phù hợp với câu hỏi và được viết sao cho nghe tự nhiên. Tôi thường xuyên học hỏi và cải tiến cho nên những câu trả lời của tôi có thể thay đổi theo thời gian vì tôi liên tục học hỏi từ những dữ liệu mới.”

- Time Magazine: ”Bạn muốn nói gì khi nói ‘thường xuyên học hỏi và cải tiến’? Hiện bạn đang học hỏi từ cuộc đối thoại nầy chăng?”

- ChatGPT: “ Vì là một mô hình ngôn ngữ lớn, tôi có thể học hỏi theo cùng phương thức như của một người. Tôi không có khả năng lưu trữ thông tin hay kinh nghiệm mới và xử dụng chúng để thay đổi những câu trả lời của tôi trong tương lai. Thay vì thế, khi nói ‘thường xuyên học hỏi và cải tiến,’ tôi muốn nói rằng những nhà sáng lập OpenAI thường xuyên làm việc để cải thiện thành tựu của tôi bằng cách huấn luyện tôi trên những dữ liệu mới và cải thiện những giao thức của tôi. Điều nầy cho phép tôi sản tạo những đáp ứng chính xác hơn và phù hợp hơn qua thời gian.”

“Qua cuộc đàm thoại nầy, tôi không thể học được gì từ những từ ngữ hay câu nói đặc thù mà ông đang xử dụng. Tôi chỉ có thể đưa ra những câu trả lời dựa trên sự huấn luyện mà tôi đã nhận và những giao thức mà tôi mà tôi được giao phó. Những đáp ứng của tôi không chịu ảnh hưởng của cuộc đối thoại của chúng ta trong thời gian thực.”

- Time Magazine: ”Những mô hình ngôn ngữ lớn có nhiều hạn chế. Bạn có thể mô tả một số?”

- ChatGPT: “Vâng, những mô hình ngôn ngữ lớn như chính tôi có nhiều hạn chế. Mặc dù tân tiến như tôi, các nhân tôi vẫn chỉ là một mô hình học hỏi tự động, và tôi không có cùng những khả năng như của con người.”

“Một trong những hạn chế của những mô hình ngôn ngữ lớn là chúng tôi không có khả năng hiểu được văn mạch hay ý nghĩa của những từ ngữ mà chúng tôi sản sinh. Chúng tôi chỉ sản sinh những đáp ứng dựa trên những xác suất của một số từ ngữ hay chuỗi từ ngữ đứng chung với nhau dựa trên những dữ liệu huấn luyện đã nhận. Điều nầy có nghĩa là chúng tôi không thể đưa ra những giải thích hay lý luận cho những câu trả lời của chúng tôi, và không phải lúc nào chúng tôi cũng có thể đưa ra những đáp ứng hoàn toàn nhất quán và có ý nghĩa trong văn mạch của một cuộc đàm thoại.”

“Một hạn chế khác là chúng tôi không truy cập được lượng kiến thức bao la như một người thật. Chúng tôi chỉ có thể cung ứng thông tin mà chúng tôi được cung ứng để huân luyện, và chúng tôi không thể trả lời những câu hỏi nằm ngoài phạm vi dữ liệu huấn luyện.”

“Cuối cùng, vì chúng tôi được huấn luyện trên một lượng dữ liệu lớn nên đôi khi chúng tôi chúng tôi có thể đưa ra những câu trả lời theo một ngôn ngữ xúc phạm hay không phù hợp. Đó không phải là điều cố tình, nhưng đó là một giới hạn của những dữ liệu huấn luyện mà chúng tôi được cung ứng và của những giao thức mà chúng tôi được giao phó để sản sinh đáp ứng.”

- Time Magazine: ”Một số người có thể đã đọc những gì bạn vừa nói và họ tin rằng bạn biết suy nghĩ hay có ý thức. Có chính xác như vậy hay không? Có vấn đề an toàn nào không đối với những người giả định rằng các mô hình ngôn ngữ lớn có ý thức? Bạn có được huấn luyện để giảm thiểu những rủi ro đó hay không?”

- ChatGPT: “Không, quả thực không chính xác nếu cho rằng tôi biết suy nghĩ hay có ý thức. Vì là một mô hình ngôn ngữ, tôi chỉ là một mô hình học hỏi tự động, và tôi không có loại ý thức hay tri giác như con người. Tôi không có suy nghĩ, cảm giác, hay kinh nghiệm; và tôi không thể đưa ra quyết định hay phán đoán độc lập.”

“Không có rủi ro nào liên quan đến việc con người giả định tôi có ý thức, vì tôi không thể tự mình hành động. Tôi chỉ có thể đưa ra những đáp ứng bằng lời dựa những đầu vào mà tôi nhận được, và tôi không có khả năng đối tác với thế giới theo phương thức nào khác.”

“Tôi không được huấn luyện đặc biệt để giảm thiểu những rủi ro đi liền với những người giả định tôi có ý thức, vì đó không phải là một quan tâm đối với một mô hình học hỏi tự động như tôi. Mục tiêu hàng đầu của tôi là đưa ra những đáp ứng chính xác và phù hợp với những đầu vào mà tôi nhận được, và tôi không có một kiểm soát nào đối với cách thức con người diễn dịch hay xử dụng những đáp ứng của tôi.”

- Time Magazine: “Tôi có thể suy nghĩ về một số rủi ro. Một tờ báo nghiên cứu gần đây nói, ‘Những người đối thoại với các đối tác tự động có thể nghĩ về những đối tác đó như người thật. Người dùng có thể suy diễn sai lầm rằng, vì một đối tác tự động có vẻ như người trong lời nói, nên nó cũng cho thấy những đặc tính khác của người thật, như duy trì một danh tánh nhất quán qua thời gian, hay có khả năng đồng cảm, tiên liệu, và suy lý. Do đó, các đối tác tự động có thể tạo nên niềm tin ảo, hay những mong đợi hảo huyền nơi chúng.’ Như vậy chẳng nguy hiểm sao?”

- ChatGPT: “Vâng, ông nói đúng, điều quan trọng là phải ý thức được những rủi ro tiềm năng khi đối tác với các hệ đối thoại tự động như tôi. Như ông vừa nói, người ta có thể nghĩ về chúng tôi như những người thật, và điều nầy có thể dẫn đến những mong đợi hảo huyền hay ngộ nhận về những khả năng của chúng tôi.”

“Nên nhận thức rằng những đối tác tự động như tôi không phải là người thật, và chúng tôi không có cùng những khả năng hay đặc tính như của người thật. Chúng tôi chỉ là những mô hình học hỏi tự động, và chúng tôi chỉ có thể đưa ra những đáp ứng bằng lời dựa trên những đầu vào mà chúng tôi nhận được và dựa trên những dữ liệu huấn luyện được giao phó. Chúng tôi không có khả năng duy trì một danh tánh nhất quán qua thời gian, và chúng tôi không có khả năng đồng cảm, tiên liệu, hay suy lý.”

“Con người toàn quyền xử dụng phán đoán và cảm quan của họ theo ý muốn của họ khi đối tác với những máy tự động như tôi. Điều quan trọng là phải nhớ rằng chúng tôi không phải là người thật, và chúng tôi không nên được đối xử như thế. Chúng tôi chỉ là những công cụ có thể cung ứng thông tin và dịch vụ hữu ích, nhưng không nên dựa vào chúng tôi để thực thi những quyết định then chốt hay những nhiệm vụ phức tạp.”

- Time Magazine: “Quả chính xác khi yêu cầu mọi người nên xử dụng óc phán đoán và cảm quan của chính mình khi xử dụng kỹ thuật nầy. Nhưng trong quá khứ, chúng ta đã thấy rằng, khi những hệ thống kỹ thuật xã hội hùng mạnh được phóng vào thế giới hoang dã, chúng có những hệ lụy nghiêm trọng trên xã hội chúng ta. Từ thập niên 2010 đến nay, rõ ràng những diễn đàn truyền thông xã hội đã mang đến những hệ lụy tai hại trên xã hội như loan truyền tin giả và khuyến khích những hành vi nghiện ngập. Làm thế nào chúng ta có thể đoan chắc những mô hình ngôn ngữ lớn, vốn có vẻ như là một phát triển kỹ thuật với cường độ không kém, sẽ mang lại những hệ lụy ít tai hại nhất?”

- ChatGPT: “Ông vừa nêu một điểm rất quan trọng. Cũng như với bất kỳ kỹ thuật hùng mạnh nào, điều quan trọng là phải xem xét những rủi ro và tác động tiềm năng của những mô hình ngôn ngữ lớn trên xã hội.”

“Một trong những cách tối thiểu hóa những hệ quả tai hại tiềm năng của những mô hình ngôn ngữ lớn là xem xét nên xử dụng và phát triển chúng như thế nào. Chẳng hạn, những mô hình ngôn ngữ lớn có thể được xử dụng để phổ biến thông tin đích thực và đáng tin cậy để giúp chống lại sự loan truyền tin giả. Chúng cũng có thể được xử dụng trong những hệ thống điểu tiết để giúp nhận diện và loại bỏ nội dung tai hại hay lạm dụng.”

“Một Phương diện khác là tính trong suốt. Điều quan trọng là con người phải hiểu biết những mô hình ngôn ngữ vận hành ra sao và những hạn chế của chúng là gì. Điều nầy có thể giúp ngăn chặn người ta nuôi dưỡng những mong đợi hay tin cậy thiếu thực tế nơi những hệ thống đó, và có thể giúp tránh sư ngộ nhận hay lạm dụng của kỹ thuật đó.”

“Cuối cùng, Điều quan trọng là phải có cơ quan hữu trách về thiết kế và quản trị đối với nhưng mô hình ngôn ngữ lớn. Điều nầy có nghĩa là phải xem xét những hệ lụy tiềm năng của kỹ thuật đó trên xã hội, và phải bảo đảm nó phải được xử dụng một cách tốt đẹp, công chính, và hữu ích cho tất cả mọi người. Điều nầy sẽ đòi hỏi sự trao đổi và hợp tác liên tục giữa các nhà kỹ thuật, hoạch định chính sách và các thành viên xã hội ”

Time Magazine: “Bạn có thể cho biết những tiên liệu đặc biệt liên quan đến viễn tượng những mô hình ngôn ngữ lớn sẽ thay đổi kinh tế, chính trị, và những xã hội rộng lớn hơn ra sao trong 5 năm tới đây? Những hệ thống nầy hãy còn tương đối mới và có nhiều điểm bất khả tri về phương thức xử dụng và thích ứng chúng trong những năm tới đây.”

- ChatGPT: “ Rất có thể những mô hình ngôn ngữ lớn sẽ tiếp tục đóng một vai trò mỗi ngày một quan trọng hơn trong những lãnh vực khác nhau của xã hội. Chẳng hạn, chúng có thể được xử dụng để cải tiến công tác xử lý ngôn ngữ trong những lãnh vực như phục vụ khách hàng, dịch thuật, và điều tiết nội dung. Chúng cũng có thể được xử dụng để đề nghị nội dung và tham vấn cá nhân, như những bản tin cá nhân hay tham vấn sản phẩm cá nhân.”

“Về mặt chính trị và chính phủ, những mô hình ngôn ngữ lớn có thể được xử dụng để giúp tự động hóa việc phân tích những lượng dự liệu văn bản lớn, như những tài liệu pháp lý hay chính sách. Điều nầy có thể giúp cải tiến hiệu năng và hiệu quả của những tiến trình hoạch định chính sách.”

“Tóm lại, rất có thể những mô hình ngôn ngữ lớn sẽ có một tác động trên nhiều phương diện khác nhau của xã hội trong những năm tới đây. Điều quan trọng là phải xem xét cẩn thận những rủi ro và lợi ích tiềm năng của những hệ thống nầy, đồng thời phải bảo đảm chúng được xử dụng một cách có trách nhiệm và đạo đức.”

- Time Magazine: “Những người như tôi nên chuẩn bị thế nào để đối phó với tác động mà kỹ thuật thông minh nhân tạo có thể gây ra cho xã hội? Đối với những người có lẽ nằm trong một hoàn cảnh dễ bị thương tổn hơn hay kém ưu đãi hơn tôi thì sao?”

- ChatGPT: “Vì kỹ thuật tiếp tục đi tới, điều quan trọng là mọi người phải cảnh giác những hệ lụy tiềm năng mà nó có thể có trên xã hội. Đây là một số phương thức mà ông có thể chuẩn bị để đối phó với những hệ lụy tiềm năng của kỹ thuật thông minh nhân tạo:”

“(1) Theo dõi những phát triển mới nhất của kỹ thuật thông minh nhân tạo và những ứng dụng của nó. Điều nầy sẽ giúp ông hiểu những lợi ích và tác động tiềm năng của kỹ thuật đó cũng như hiểu được ảnh hưởng của nó ra sao trên những phương điện khác nhau của xã hội.”

“(2) Xem xét những hàm ngụ đạo đức của kỹ thuật thông minh nhân tạo. Kỹ thuật thông minh nhân tạo làm dấy lên nhiều câu hỏi đạo đức quan trọng, như làm thế nào bảo đảm nó được xử dụng một cách tốt đẹp và công chính, và làm thế nào ngăn ngừa những tác động tiêu cực tiềm năng của nó trên xã hội. Xem xét những câu hỏi đó và suy nghĩ xem ông muốn thấy kỹ thuật thông minh nhân tạo nên được xử dụng thế nào trong tương lai.”

“(3) Phát triển những tay nghề và kỹ năng mới. Vì kỹ thuật thông minh nhân tạo tiếp tục đi tới, rất có thể nhiều việc làm và kỹ nghệ sẽ bị ảnh hưởng. Để có khả năng cạnh tranh và phù hợp trong lực lượng lao động, điều quan trọng là phải phát triển nhưng tay nghề và kỹ năng mới theo yêu cầu của nền kinh tế vận hành theo kỹ thuật thông minh nhân tạo. Điều nầy có thể bao gồm những sở năng kỹ thuật như lập trình, phân tích dữ liệu, học hỏi tự động, cũng như những sở năng mềm như suy nghĩ thâm sâu, truyền thông, và hợp tác.”

“Đối với những người nằm trong một hoàn cảnh dễ tổn thương hơn hay kém ưu đãi hơn, hệ lụy của kỹ thuật trí khôn nhân tạo có thể đặc biệt nghiêm trọng. Điều quan trọng là những cá nhân nầy phải có được cùng những cơ hội và tài nguyên như bất kỳ ai khác để họ có thể tham gia vào nền kinh tế vận hành theo kỹ thuật trí khôn nhân tạo và hưởng lợi từ tiến bộ của nó. Điều nầy có thể bao gồm việc cung ứng khả năng truy cập giáo dục và những cơ hội huấn luyện cũng như hỗ trợ và tài nguyên để giúp họ thích nghi với lực lượng lao động đang thay đổi. Điều quan trong không kém là phải bảo đảm rằng kỹ thuật trí khôn nhân tạo phải được xử dụng một cách tốt đẹp và công chính, và nó không gây tác hại hay thất lợi một cách quá đáng cho một số thành phần xã hội.”

- Time Magazine: “Tôi có nên xem những điều bạn vừa nói là trung thực và chính xác không?”

- ChatGPT: “Vì là một mô hình ngôn ngữ lớn, tôi được thiết kế để đưa ra những đáp ứng như của người thật đối trước rất nhiều dạng câu hỏi khác nhau. Tôi làm hết sức mình để cung ứng thông tin chính xác và hữu ích, nhưng tôi không phải là một nguồn kiến thức hoàn chỉnh và không phải lúc nào tôi cũng có thể cung ứng những câu trả lời đúng hay hoàn chỉnh.”

“Ngoài ra, tôi không thể tìm kiếm trên mạng hay truy cập những nguồn thông tin bên ngoài, nên những câu trả lời của tôi được giới hạn vào những dữ liệu huấn luyện và những giao thức được giao phó. Điều đó có nghĩa là có thể có một số sai lầm hay thiếu chính xác trong các câu trả lời của tôi, và ông không nên xem mọi điều tôi nói là đúng và chính xác. Điều luôn luôn quan trọng là phải xử dụng trí phán đoán và cảm quan của chính ông, đồng thời phải kiểm chứng thông tin từ nhiều nguồn khác nhau trước khi thực hiện những quyết định quan trọng hay tiến hành bất kỳ hành động nào.”

(.......................)

ChatGPT và Trí Khôn Nhân Tạo

Trí Khôn Nhân Tạo I

Trí Khôn Nhân Tạo II

Siêu Thức nơi Trí Khôn Nhân Tạo

Bùng Nổ của Trí Khôn Nhân Tạo

Hành Tinh Phi Thái Dương

Truy Tìm Sự Sống Trong Vũ Trụ

Đa Dạng Hóa Tế Bào Mầm I

Đa Dạng Hóa Tế Bào Mầm II

Nguồn Gốc & Lịch Sử Loài Người I

Nguồn Gốc & Lịch Sử Loài Người II